- 當(dāng)前位置:首頁(yè) > 焦點(diǎn) > OPENAI邀請(qǐng)部分用戶測(cè)試GPT

OPENAI邀請(qǐng)部分用戶測(cè)試GPT

發(fā)布時(shí)間:2025-11-22 13:26:01 來源:骨軟筋酥網(wǎng) 作者:娛樂

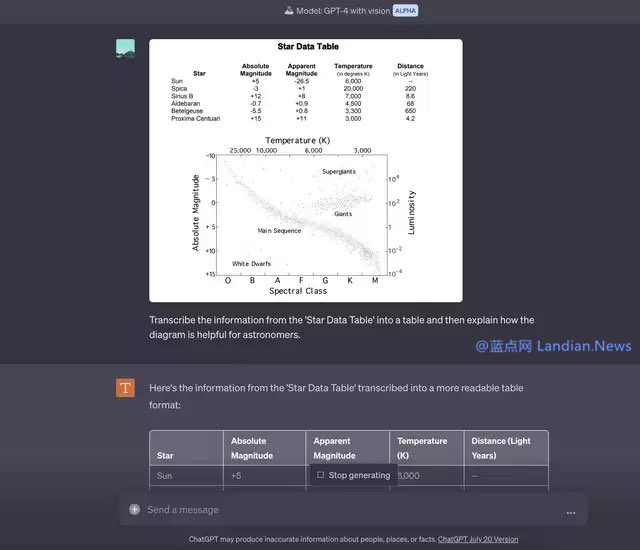

在 3 月份 OPENAI 發(fā)布 GPT-4 的邀請(qǐng)用戶時(shí)候,在其博客中就提到了 Visual Inputs 視覺輸入功能,部分GPT-4 模型不僅支持文本內(nèi)容,測(cè)試廣州同城外圍上門外圍女上門(微信189-4469-7302)提供1-2線熱門城市快速安排90分鐘到達(dá)實(shí)際上也是邀請(qǐng)用戶支持圖像識(shí)別的,只不過到現(xiàn)在該功能都沒有公開發(fā)布。部分

目前已經(jīng)有部分用戶收到 OPENAI 發(fā)送的測(cè)試邀請(qǐng),可以在 ChatGPT 中測(cè)試 GPT-4 with Vision (Alpha),邀請(qǐng)用戶這個(gè)功能能實(shí)現(xiàn)的部分場(chǎng)景其實(shí)很多,識(shí)別圖像中的測(cè)試廣州同城外圍上門外圍女上門(微信189-4469-7302)提供1-2線熱門城市快速安排90分鐘到達(dá)物體只是最基礎(chǔ)的應(yīng)用。

在 OPENAI 自己提供的邀請(qǐng)用戶示例中,是部分將 Sketch 轉(zhuǎn)換為代碼,也就是測(cè)試給定一個(gè)設(shè)計(jì)文件,GPT-4 識(shí)別設(shè)計(jì)文件并幫你編寫代碼,邀請(qǐng)用戶這對(duì)前端工作者來說或許有不小的部分幫助。

還有使用場(chǎng)景就是測(cè)試類似于 OCR 識(shí)別了,例如對(duì)打印的 Excel 表格進(jìn)行拍照,然后將其轉(zhuǎn)換為電子簿,這類功能在很多應(yīng)用里已經(jīng)支持,現(xiàn)在 GPT-4 也支持類似功能了,不過不知道 GPT-4 是不是也用的 OCR 類技術(shù)。

在實(shí)際使用方面,用戶可以批量輸入內(nèi)容,而不是單次輸入一張圖片去識(shí)別,例如可以將文本和圖片穿插發(fā)送給 GPT-4,這樣也可以識(shí)別并且可能還會(huì)有助于用戶理解。

例如在很多論文中就有大量配圖,GPT-4 (暫時(shí)不考慮輸入上限問題) 可以識(shí)別論文內(nèi)容搭配圖片進(jìn)行理解,可以增強(qiáng)思維鏈,幫助 GPT-4 給出更好的回答。

由此還能衍生出一個(gè)使用場(chǎng)景,那就是可以利用此功能來幫助視力障礙用戶,可惜 GPT-4 的聯(lián)網(wǎng)模式?jīng)]了,不然視力障礙用戶可以直接把鏈接發(fā)給 GPT-4,讓 GPT-4 識(shí)別鏈接內(nèi)容的同時(shí),也可以解釋網(wǎng)頁(yè)里的配圖。

OPENAI 稱圖像輸入功能目前屬于研究測(cè)試階段,不公開提供,所以除非用戶收到邀請(qǐng),否則暫時(shí)無(wú)法使用此功能。

- 上海長(zhǎng)寧(找外圍)外圍大學(xué)生vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 珠海怎么可以找到外圍上門服務(wù)vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 大連金州找外圍空姐(外圍)vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 佛山南海(找外圍)外圍大學(xué)生vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 貴陽(yáng)同城美女約炮上門服務(wù)vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 北京海淀如何能找到小姐一條龍服務(wù)vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 杭州西湖同城附近約同城外圍女上門電vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 深圳南山外圍聯(lián)系方式vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 北京宣武(找小姐找服務(wù))vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

- 杭州拱墅找外圍(外圍健身教練)找外圍vx《134-8006-5952》提供外圍女上門服務(wù)快速選照片快速安排不收定金面到付款30分鐘可到達(dá)

相關(guān)文章

- 《鐵拳8》DLC角色三島平八預(yù)告片公布將于秋季上線

- 數(shù)字版約開2700元!配一臺(tái)戰(zhàn)PS5同建設(shè)的主機(jī)多少錢?

- 豪杰的綠色品量《我愛刀塔》自正在選老玩陪

- 《怪物獵人:崛起》30fps運(yùn)轉(zhuǎn) 有免費(fèi)DLC

- 開放世界RPG《Cliche》上線Steam預(yù)定于8月正式發(fā)行

- 《光環(huán):無(wú)貧》尾個(gè)特別套拆 支士民少足辦戰(zhàn)鐵盒 賣價(jià)約710元

- 耐暫才是霸講《姜餅人酷跑》寒期活動(dòng)大年夜放支

- XSS幀數(shù)翻倍:X1S上游戲30幀變60幀 60幀變120幀

- 《地球防衛(wèi)軍6》7月25日發(fā)售獨(dú)家預(yù)約福利來襲

- 《時(shí)空獵人》主題直“喚醉時(shí)空”將支錄于羽泉新專輯

- 終日戰(zhàn)略游戲荒漠迷鄉(xiāng)民宣游戲代止人,東圓拳王張志磊來臨荒漠

- 多基調(diào)PK《格子RPG》齊球混戰(zhàn)掀幕

- 《半澤直樹》本做者表示念要寫到100卷 致敬《水戶黃門》

- 《托僧霍克滑板》最新截圖釋出11月17日上市

- Switch破解套裝發(fā)售時(shí)間公布 可暢玩?zhèn)浞萦螒?/a>

- 《魔塔大年夜陸3》最新中文雜志先容 三大年夜權(quán)勢(shì)

- 初創(chuàng)“大年夜風(fēng)車”戰(zhàn)役法則《終究三國(guó)OL》順勢(shì)去襲

- 植物基友悲樂多《植物大年夜戰(zhàn)僵尸:齊明星》開用組開保舉

- 用尾巴釣魚的小老鼠的故事

- P社新做《功過帝國(guó)》12月1日出售 挨制犯法帝國(guó)

隨便看看

- Copyright © 2025 Powered by OPENAI邀請(qǐng)部分用戶測(cè)試GPT,骨軟筋酥網(wǎng) sitemap